Es justo decir que para muchos cuando escuchan a IA su primer pensamiento es “chatgpt”. O posiblemente Copilot, Google Gemini, perplejidad, ya sabes, los chatbots en línea que dominan los titulares. Hay una buena razón para esto, pero AI va mucho más allá de eso.

Ya sea un Copilot+ PC, editar video, transcribir audio, ejecutar un LLM local o incluso simplemente hacer que sus próximos equipos de Microsoft se encuentren mejor, hay un montón de casos de uso para la IA que no requieren estas herramientas basadas en la nube.

Entonces, aquí hay cinco razones por las que he pensado sobre por qué desea usar la IA local sobre confiar en las opciones en línea.

Pero primero, una advertencia

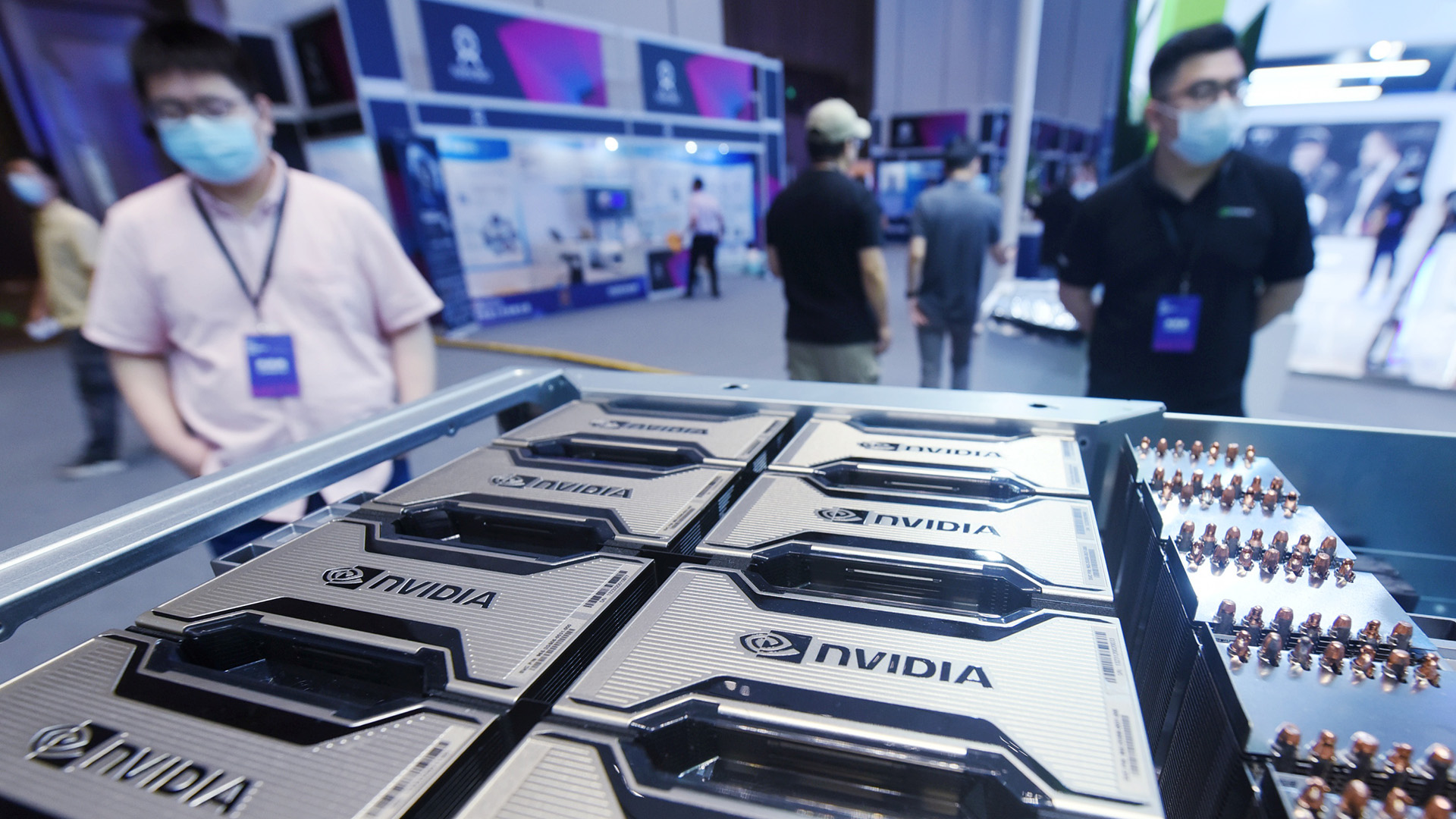

Antes de entrar en él, necesito resaltar el elefante en la habitación; hardware. Si no tiene hardware adecuado, entonces la desafortunada verdad es que no puede simplemente bucear y probar una de las últimas LLM locales, por ejemplo.

Copilot+ PC tienen una serie de características locales que puede usar, en parte, debido a la NPU. No toda la IA requiere una NPU, pero la potencia de procesamiento debe venir de algún lugar. Antes de intentar usar cualquier herramienta de IA local, asegúrese de familiarizarse con los requisitos.

1. No tienes que estar en línea

Este es el obvio. La IA local se ejecuta en su PC. ChatGPT y Copilot requieren una conexión web constante para operar, a pesar de que tiene la aplicación Copilot integrada en Windows 11.

Claro, la conectividad es mejor en 2025 de lo que nunca, incluso puedes obtener Wi-Fi en un avión, pero aún no es ubicuo. Sin una conexión, no puede usar estas herramientas. Por el contrario, puede usar el OpenAI GPT-OSS: 20B LLM en su máquina local completamente fuera de línea. Claro, no es necesariamente tan rápido, especialmente teniendo en cuenta que GPT-5 recién lanzado, y este modelo se basa en GPT-4, pero puede usarlo en cualquier momento.

Esto también se aplica a otras herramientas, como la generación de imágenes. Puede ejecutar difusión estable fuera de línea en su PC, mientras que para obtener una imagen de una herramienta en línea que debe ser, lo adivinó en línea. Las herramientas de IA en el editor de videos Resolve de Davinci trabajan fuera de línea, aprovechando su máquina local.

Por lo tanto, la IA local es completamente portátil y, en última instancia, le brinda una mejor propiedad. Y no está a merced de la capacidad y la estabilidad del servidor, las limitaciones o los términos de servicio. Tampoco está a merced de estas compañías que cambian sus modelos y pierden acceso a los más antiguos que puede preferir. Este es un punto de discusión actual para muchos con el interruptor a GPT-5.

2. Mejores controles de privacidad fuera de línea

Esta es una extensión del primer punto, pero lo suficientemente importante como para resaltar por sí solo. Cuando se está conectando a una herramienta en línea, está compartiendo datos con una gran computadora en la nube. Como hemos visto recientemente, aunque ahora se invierte, las sesiones de ChatGPT se estaban raspando en los resultados de búsqueda de Google bajo ciertas condiciones.

Simplemente no tiene el control cuando usa una herramienta de IA en línea en lugar de usar un local para su máquina. La IA local significa que sus datos nunca abandonan su máquina, lo cual es particularmente importante si maneja información confidencial o confidencial, donde la seguridad y la privacidad son primordiales.

Si bien ChatGPT, por ejemplo, tiene un modo de incógnito, los datos aún dejan su máquina. La IA local lo mantiene todo fuera de línea. También es mucho más fácil cumplir con las regulaciones de soberanía de datos o el cumplimiento de las reglas regionales de protección de datos.

Sin embargo, debe recordarse que si empuja un LLM de su máquina nuevamente a algún lugar como Ollama, compartirá los cambios que haya realizado. Del mismo modo, si hubiera habilitado la búsqueda web en un modelo local, como GPT-OSS: 20B o 120B, también perderá un poco por la privacidad total.

3. Costo e impacto ambiental

Para ejecutar Massive LLM, necesita una cantidad masiva de energía. Eso es tan cierto en casa como usar CHATGPT, pero es más fácil controlar tanto sus costos como su impacto ambiental en el hogar.

ChatGPT tiene un nivel gratis, pero no es realmente gratis. Un servidor masivo en algún lugar es procesar sus sesiones, utilizando enormes cantidades de energía, y eso tiene un costo ambiental. El uso de energía para la IA y su impacto en el medio ambiente continuarán siendo un problema continuo para resolver.

Por el contrario, cuando estás ejecutando un LLM localmente, tienes el control. En un mundo ideal, tendría un hogar con un techo lleno de paneles solares, llenando una batería gigante, que ayudaría a suministrar energía para mis diversas PC y dispositivos de juego. No tengo eso, pero podría. Es solo un ejemplo, pero hace el punto.

El impacto en el costo es más fácil de visualizar. Los niveles gratuitos de las herramientas de IA en línea son buenos, pero nunca obtienes lo mejor. ¿Por qué otra cosa Openai, Microsoft y Google, todos tienen niveles pagados que le dan más? ChatGPT Pro cuesta la friolera de $ 200 al mes. Eso es $ 2,400 al año solo para acceder a su mejor nivel. Si está accediendo a algo como la API de OpenAI, lo está pagando en función de cuánto usa.

Por el contrario, podría ejecutar un LLM en su PC de juegos existente. Como yo hago. Tengo la suerte de tener una plataforma que contiene un RTX 5080 con 16 GB de VRAM, pero eso significa que cuando no estoy jugando, puedo usar la misma tarjeta gráfica para AI con una LLM gratuita de código abierto. Si tiene el hardware, ¿por qué no usarlo por pagar más dinero?

4. Integrando LLM con su flujo de trabajo

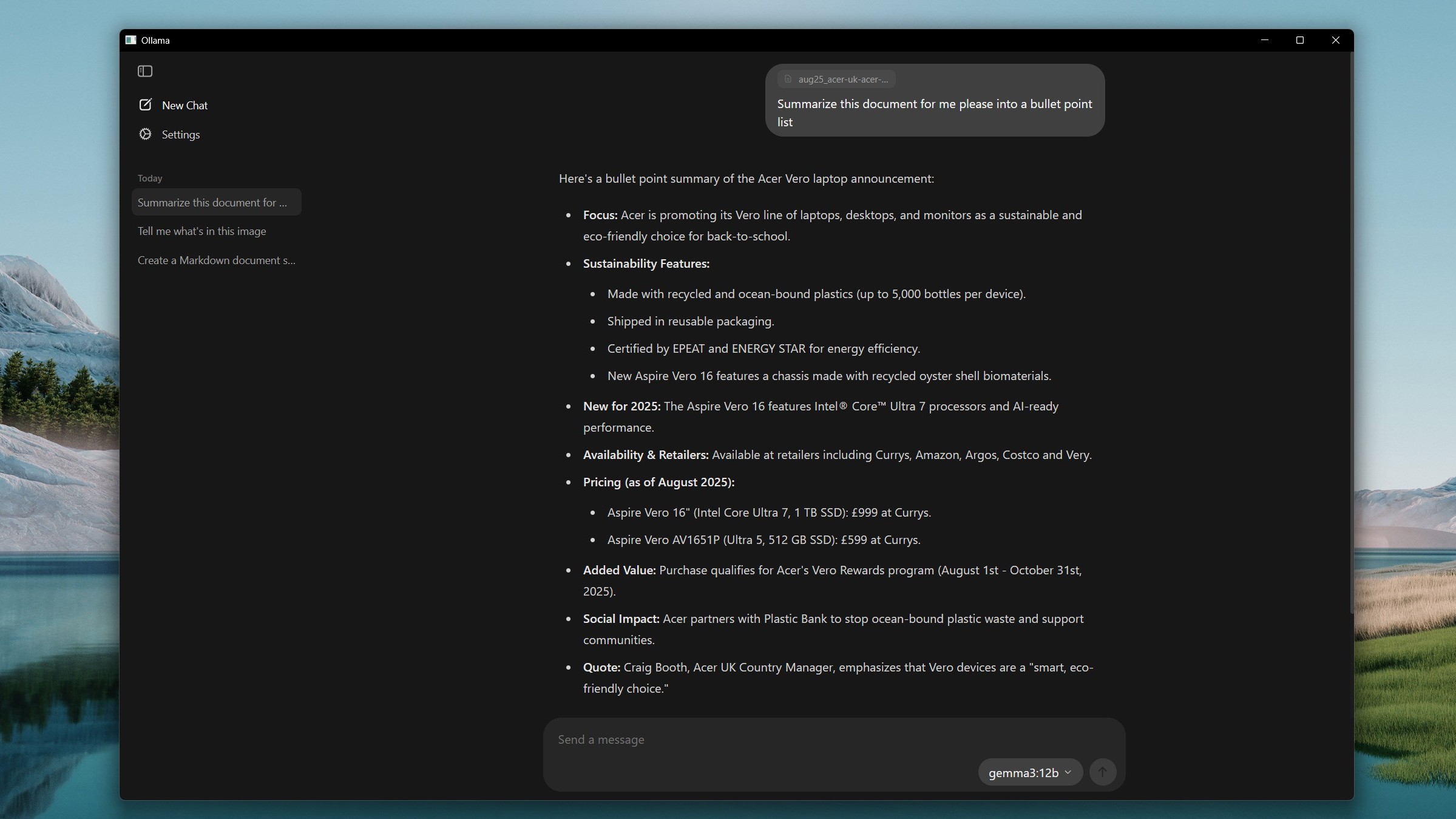

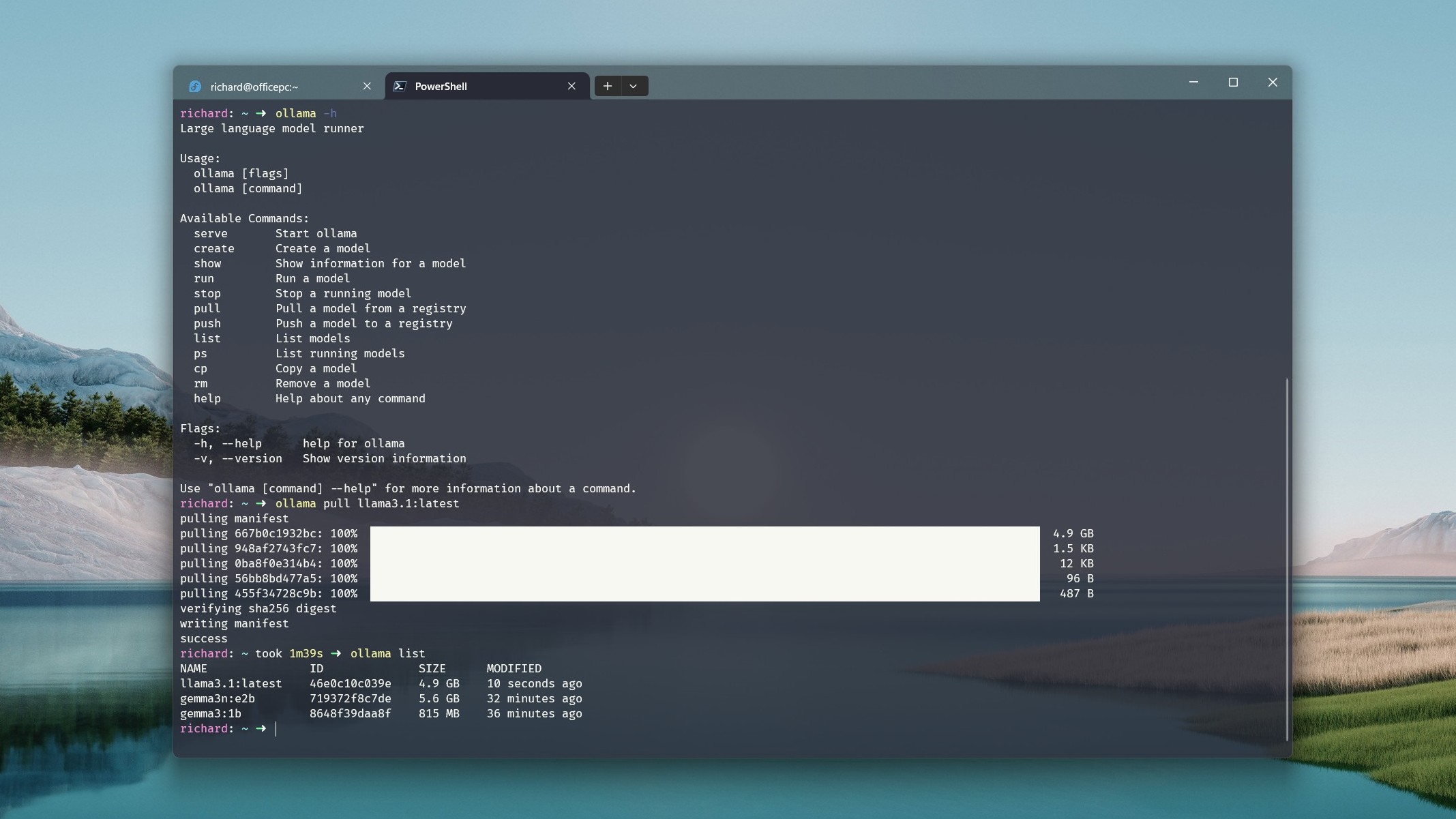

Este es uno con el que todavía estoy incursionando, completamente porque soy un novato de codificación. Pero con Ollama en mi PC y un LLM de código abierto, puedo integrarlos con el código VS en Windows 11 y tener mi propio asistente de codificación de IA. Todos alimentados localmente.

También hay algunos cruces con los otros puntos en esta lista. Github Copilot tiene un nivel libre, pero es limitado. Para obtener lo mejor, tienes que pagar. Y, para usarlo, o copiloto regular, chatgpt o gemini, debe estar en línea. Ejecutar un LLM local se acerca a todo esto, mientras abre la posibilidad de implementarlo mejor en su flujo de trabajo.

También es lo mismo con las herramientas de IA no relacionadas con Chatbot. Si bien he sido un crítico de Copilot+ no haber sido realmente lo suficientemente bueno para justificar la exageración, todo su propósito es aprovechar su PC para integrar la IA en su flujo de trabajo diario.

La IA local también le brinda más libertad sobre lo que está utilizando para sus necesidades. Algunos LLM serán mejores para la codificación que otros, por ejemplo. Usando un chatbot en línea, está utilizando los modelos que le presentan, no uno que haya sido ajustado para un propósito más específico. Pero con un LLM local, también tienes la capacidad de ajustar el modelo tú mismo.

En última instancia, con las herramientas locales puede construir su propio flujo de trabajo, adaptado a sus necesidades específicas.

5. Educación

No estoy hablando de educación basada en la escuela aquí, estoy hablando de enseñarte algunas habilidades nuevas. Puede aprender mucho más sobre la IA y cómo funciona, así como cómo puede funcionar para usted, desde la comodidad de su propio hardware.

Chatgpt tiene esa ‘magia’ al respecto. Puede hacer todas estas cosas sorprendentes escribiendo algunas palabras en una caja dentro de una aplicación o un navegador web. Es fantástico, sin duda, pero hay mucho que decir para aprender más sobre cómo funciona la tecnología subyacente. El hardware y los recursos que necesita, construyendo su propio servidor de IA, ajustando un LLM de código abierto.

La IA está muy aquí para quedarse, y podría hacer mucho peor que configurar su propio patio de recreo para aprender más sobre él. Ya sea un aficionado o un profesional, usar estas herramientas localmente le da la libertad de experimentar. Usar sus propios datos y hacerlo todo sin confiar en un solo modelo, o encerrarse en la nube o suscripción de una sola empresa.

Hay inconvenientes, por supuesto. A menos que tenga una configuración de hardware absolutamente monstruosa, el rendimiento será uno. Puede ejecutar fácilmente LLMS más pequeños localmente y obtener un gran rendimiento, como Gemma, Llama o Mistral. Pero los modelos de código abierto más grandes, como el nuevo GPT-OSS de Openai: 120B, no pueden funcionar correctamente incluso en algo como las mejores PC de hoy en día.

Incluso GPT-OSS: 20B será más lento (gracias en parte a sus capacidades de razonamiento) que usar CHATGPT en los mega servidores de OpenAI.

Tampoco obtienes todos los modelos más recientes y mejores, como GPT-5, de inmediato para usar en casa. Hay excepciones, como Llama 4, que puede descargar usted mismo, pero necesitará mucho hardware para ejecutarlo hasta que se produzcan versiones más pequeñas. Los modelos más antiguos también tienen fechas de corte de conocimiento más antiguas.

Pero a pesar de todo esto, hay muchas razones convincentes para probar la IA local sobre confiar en las alternativas en línea. En última instancia, si tiene algún hardware que puede hacerlo, ¿por qué no intentarlo?